Liudef/XB_F.1_MIX AI图像生成模型

基于FLUX.1-dev架构的高级AI图像生成模型,继承Diffusion Transformer (DiT) 纯Transformer架构, 支持多尺度训练、动态提示词解析、LoRA生态支持

基于FLUX.1-dev架构的高级AI图像生成模型,继承Diffusion Transformer (DiT) 纯Transformer架构, 支持多尺度训练、动态提示词解析、LoRA生态支持

XB_F.1_MIX基于Black Forest Labs发布的FLUX.1-dev微调而成,采用扩散变换器架构, 实现了更好的扩展性和性能

负责图像与潜在空间之间的转换,实现高效的编码解码过程

处理文本提示词,将自然语言转换为模型可理解的嵌入表示

执行扩散去噪过程,逐步从噪声中重建高质量图像

控制扩散步骤,优化采样过程,提升生成效率

将文本分解为模型可处理的token序列,支持复杂提示词解析

class XB_F1_MIX_Model(nn.Module):

def __init__(self, model_path="Liudef/XB_F.1_MIX"):

super().__init__()

# 加载预训练模型组件

self.vae = AutoencoderKL.from_pretrained(model_path, subfolder="vae")

self.text_encoder = CLIPTextModel.from_pretrained(model_path, subfolder="text_encoder")

self.tokenizer = CLIPTokenizer.from_pretrained(model_path, subfolder="tokenizer")

self.unet = UNet2DConditionModel.from_pretrained(model_path, subfolder="unet")

self.scheduler = DPMSolverMultistepScheduler.from_pretrained(model_path, subfolder="scheduler")

def encode_prompt(self, prompt):

# 文本编码

text_inputs = self.tokenizer(

prompt,

padding="max_length",

max_length=self.tokenizer.model_max_length,

truncation=True,

return_tensors="pt"

)

text_embeddings = self.text_encoder(text_inputs.input_ids)[0]

return text_embeddingsXB_F.1_MIX集成了多项前沿技术,提供卓越的图像生成能力和用户体验

支持从512×512到1024×1024的多分辨率生成,同时保持细节一致性和构图稳定性。 无需额外训练即可适应不同尺寸要求。

支持权重语法:(word:weight) 或 (word)1.2,精细控制生成内容的不同方面。 权重值大于1.0增强概念表现,小于1.0减弱影响。

文本编码 → 噪声初始化 → 迭代去噪 → 图像解码的完整流程。 支持实时监控生成进度和质量。

分类器自由引导技术,通过guidance_scale参数控制条件强度。 平衡文本遵循度与生成多样性。

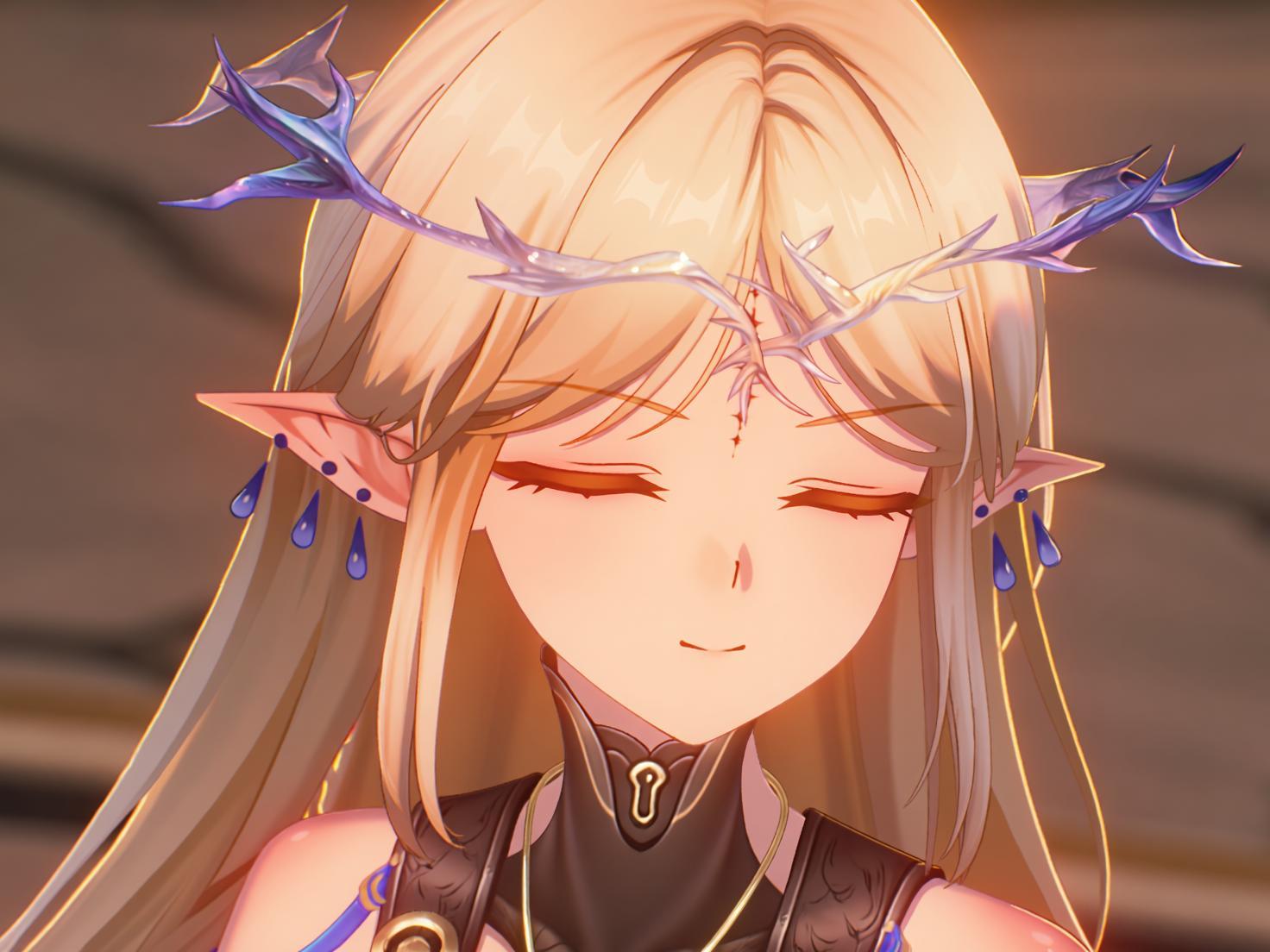

探索XB_F.1_MIX的强大生成能力,体验不同风格的AI艺术创作

东方幻想风格 • 1000×1000

XB_F.1_MIX全面支持LoRA技术,允许社区开发者使用小型适配器扩展模型能力

LoRA技术通过低秩分解大幅减少可训练参数数量,使社区开发者能够使用消费级硬件定制模型。 适配器通过两个小矩阵A和B的乘积近似权重更新,通常只需原始模型参数量的1-2%即可实现有效适配。

class LoraAdapter(nn.Module):

def __init__(self, original_layer, rank=4, alpha=8):

super().__init__()

self.original_layer = original_layer

self.rank = rank

self.alpha = alpha

# LoRA权重矩阵

self.lora_A = nn.Parameter(torch.randn(in_features, rank) * 0.02)

self.lora_B = nn.Parameter(torch.zeros(rank, out_features))

self.scaling = alpha / rank

def forward(self, x):

# 原始前向传播

original_output = self.original_layer(x)

# LoRA适配

lora_output = x @ self.lora_A @ self.lora_B * self.scaling

return original_output + lora_output提供多种部署方式和完整的API服务,降低使用门槛,快速集成到您的项目中

半精度浮点,在保持质量的同时减少50%显存占用

8位整数量化,进一步压缩模型大小和内存使用

极致压缩,适合边缘设备和移动端部署

from modelscope import snapshot_download, pipeline

import os

# 下载模型

model_dir = snapshot_download('Liudef/XB_F.1_MIX')

# 创建生成管道

generator = pipeline(

'text-to-image',

model=model_dir,

device='cuda'

)

# 生成图像

result = generator(

prompt="一位美丽的精灵公主,金色长发,蓝色眼睛,站在海边",

height=1024,

width=1024,

num_inference_steps=20

)

# 保存结果

output_path = 'generated_image.png'

result[0]['output_image'].save(output_path)from xb_f1_mix_client import XB_F1_MIX_Client

# 初始化客户端

client = XB_F1_MIX_Client(

model_path="Liudef/XB_F.1_MIX",

device="cuda",

precision="fp16"

)

# 同步生成

image = client.generate(

prompt="一位穿着汉服的女子在江南水乡",

width=1024,

height=1024,

guidance_scale=7.5,

num_inference_steps=20

)

# 异步批量生成

async def batch_generate():

prompts = [

"东方幻想风格的美丽女子",

"3D写实的仙侠角色",

"宇宙科幻场景"

]

results = await client.generate_batch(prompts)

return results将多个操作融合为单个内核,减少内存访问和计算开销

使用Torch.compile优化模型执行,提升推理速度

智能填充策略,减少不必要的计算和内存分配

缓存常用计算结果,避免重复计算